Поделитесь этой статьей

DevOps — это не просто набор инструментов, а целая культура. Название родилось из слияния двух понятий: Development (разработка) и Operations (эксплуатация).

Главная цель — объединить эти два мира, чтобы ускорить выпуск качественного программного обеспечения за счёт тесного сотрудничества.

Ключевые принципы и культура DevOps

В основе DevOps лежит прежде всего культурная революция, а не просто набор инструментов. Это философия, направленная на разрушение барьеров между разработкой (Development) и эксплуатацией (Operations). Вместо традиционного противостояния, где одни хотят изменений, а другие — стабильности, создаётся единая команда с общей целью: быстро и надёжно доставлять ценность конечному пользователю. Эта синергия достигается за счёт технологий, сильных коммуникативных навыков и взаимного доверия.

Фундаментом этой культуры служат несколько ключевых идей:

- Общая ответственность. Команда сообща владеет продуктом на всех этапах, от идеи до поддержки. Фраза «на моей машине работало» уходит в прошлое, ведь ответственность за результат теперь коллективная.

- Автоматизация всего, что возможно. Рутинные и повторяющиеся действия — сборка, тестирование, развертывание — передаются машинам. Это сокращает время, минимизирует риск человеческой ошибки и освобождает инженеров для творческих задач.

- Непрерывное улучшение. DevOps — это бесконечный цикл обратной связи. Команды постоянно измеряют результаты своей работы, анализируют ошибки и ищут способы стать эффективнее. Любой сбой — это ценный урок, а не повод для обвинений.

- Ориентация на бизнес. Любое техническое действие должно быть оправдано с точки зрения пользы для бизнеса и клиента.

Преимущества внедрения DevOps для бизнеса

Для бизнеса внедрение DevOps — это не просто следование IT-трендам, а мощный стратегический рычаг, который напрямую влияет на ключевые показатели эффективности. Это позволяет компании быстрее адаптироваться к изменениям рынка и обходить конкурентов. Происходит переход от разрозненных действий к единому, слаженному механизму доставки ценности конечному клиенту.

Основные бизнес-преимущества:

- Радикальное ускорение вывода на рынок (Time-to-Market). Автоматизация процессов сборки, тестирования и развертывания кардинально сокращает время от появления идеи до готового продукта. Новые функции и исправления доставляются пользователям не за месяцы, а за дни или даже часы.

- Повышение качества и стабильности сервисов. Благодаря непрерывному тестированию и подходу «Инфраструктура как код» (IaC), который обеспечивает повторяемость окружений, количество сбоев в продакшене резко падает. Это напрямую влияет на лояльность клиентов и репутацию бренда.

- Оптимизация расходов и ресурсов. Автоматизация рутинных задач высвобождает время дорогих специалистов для решения более сложных проблем. Меньшее количество ошибок и простоев означает прямую экономию средств на аварийном восстановлении и поддержке.

- Улучшение корпоративной культуры и сотрудничества. DevOps ломает классические барьеры между разработкой и эксплуатацией. Общие цели и совместная ответственность создают здоровую рабочую атмосферу, повышают вовлеченность сотрудников и снижают текучку кадров.

CI/CD: ядро автоматизации в DevOps

Если DevOps — это философия, то CI/CD — её практическое воплощение. Это не просто набор инструментов, а выстроенный конвейер.

Он автоматически прогоняет код через сборку, тесты и доставку, позволяя выпускать обновления для пользователей часто, быстро и с минимальными рисками.

Непрерывная интеграция (Continuous Integration)

Непрерывная интеграция (CI) — это фундаментальная практика DevOps, которая решает одну из главных головных болей разработки: так называемый «ад интеграции». Представьте команду, где каждый программист неделями пишет код в своей изолированной ветке. Когда приходит время объединить все наработки, начинается хаос из конфликтов, трудноуловимых багов и взаимных обвинений. CI предлагает простое, но гениальное решение: интегрироваться часто, в идеале — несколько раз в день, в единый центральный репозиторий.

Как это работает на практике?

Каждый раз, когда разработчик отправляет свои изменения в общую кодовую базу (например, в Git-репозиторий), запускается полностью автоматизированный процесс:

- Автоматическая сборка проекта. Специальный сервер (CI-сервер) немедленно забирает свежий код и пытается собрать из него работающее приложение. Если код даже не компилируется, команда узнает об этом мгновенно, а не через неделю перед релизом.

- Автоматическое тестирование. После успешной сборки запускается набор быстрых тестов (в первую очередь, юнит-тесты), которые проверяют, что новые изменения не сломали уже существующую логику.

- Мгновенная обратная связь. Если сборка или тесты провалились, система тут же оповещает всю команду. Это позволяет найти и исправить ошибку, пока она «горячая» и контекст не утерян.

Основная цель CI — поддерживать главную ветку репозитория в постоянно рабочем, «зелёном» состоянии. Это создаёт прочный фундамент для следующих этапов и гарантирует, что у вас всегда есть стабильная версия продукта, готовая к дальнейшим шагам, будь то доставка или развертывание.

Непрерывная доставка (Continuous Delivery)

Непрерывная доставка (CD) — это логическое и мощное расширение практики Непрерывной интеграции. Если CI гарантирует, что код в основной ветке всегда технически исправен, то CD доводит эту идею до логического завершения: каждая версия, прошедшая все автоматизированные проверки, является потенциальным кандидатом на релиз. Основная философия здесь — сделать развертывание скучным, предсказуемым и безопасным событием, которое можно выполнять в любой момент, а не героическим подвигом, требующим бессонных ночей.

Конвейер CD подхватывает артефакт сборки там, где его оставляет CI, и проводит его через серию более строгих проверок:

- Автоматическая доставка в пред-продакшн. Готовый к развертыванию пакет автоматически устанавливается на одно или несколько тестовых окружений (staging, UAT), которые по своей конфигурации максимально приближены к боевой среде.

- Всестороннее автоматизированное тестирование. На этих средах запускается целый арсенал проверок: интеграционные тесты, end-to-end тесты, тесты безопасности, а иногда и начальные нагрузочные тесты. Цель — получить максимальную уверенность в том, что релиз стабилен и не содержит регрессий.

Релиз по кнопке: контроль в руках бизнеса

Главный отличительный признак Непрерывной доставки — это то, что финальный шаг, выкатка изменений на живых пользователей (production), остается ручным. Автоматизация делает всю тяжелую работу, подготавливая релиз и держа его “на низком старте”. Однако само решение о выпуске принимается человеком. Это может быть менеджер продукта, который хочет приурочить запуск к маркетинговой акции, или команда поддержки, ожидающая наименее загруженного времени. Таким образом, техническая готовность отделяется от бизнес-решения, предоставляя компании гибкость и полный контроль над процессом выпуска продукта.

Непрерывное развертывание (Continuous Deployment)

Непрерывное развертывание (Continuous Deployment) — это вершина эволюции CI/CD и самый радикальный подход к автоматизации. Если в Непрерывной доставке финальное развертывание требовало ручного подтверждения, то здесь этот шаг полностью автоматизирован. Каждое изменение кода, успешно прошедшее все этапы автоматизированного конвейера — от сборки до интеграционных и нагрузочных тестов — автоматически попадает к конечным пользователям. Без нажатия кнопок и совещаний. Код написан, тесты пройдены — он в продакшене.

Полная автоматизация и её цена

Этот подход требует железной уверенности в качестве своего автоматизированного конвейера. Цена ошибки максимальна: баг, пропущенный тестами, мгновенно затрагивает всех пользователей. Поэтому для его внедрения необходимы зрелая инженерная культура и мощный технологический фундамент:

- Исчерпывающее тестовое покрытие. Автоматические тесты должны быть настолько надежными, чтобы команда полностью доверяла их результатам.

- Продвинутые системы мониторинга и оповещения. Необходимо мгновенно обнаруживать любые аномалии в поведении приложения после развертывания.

- Быстрые и надежные механизмы отката. Если что-то пошло не так, должна быть возможность моментально вернуть предыдущую стабильную версию.

- Применение техник безопасного развертывания (например, Canary или Blue/Green) для минимизации рисков и плавного выката на пользователей.

Непрерывное развертывание доставляет ценность пользователям с максимальной скоростью, сокращая цикл обратной связи до минимума. Это идеальный сценарий для зрелых команд и продуктов, где скорость инноваций является ключевым конкурентным преимуществом в их борьбе за лидерство на рынке.

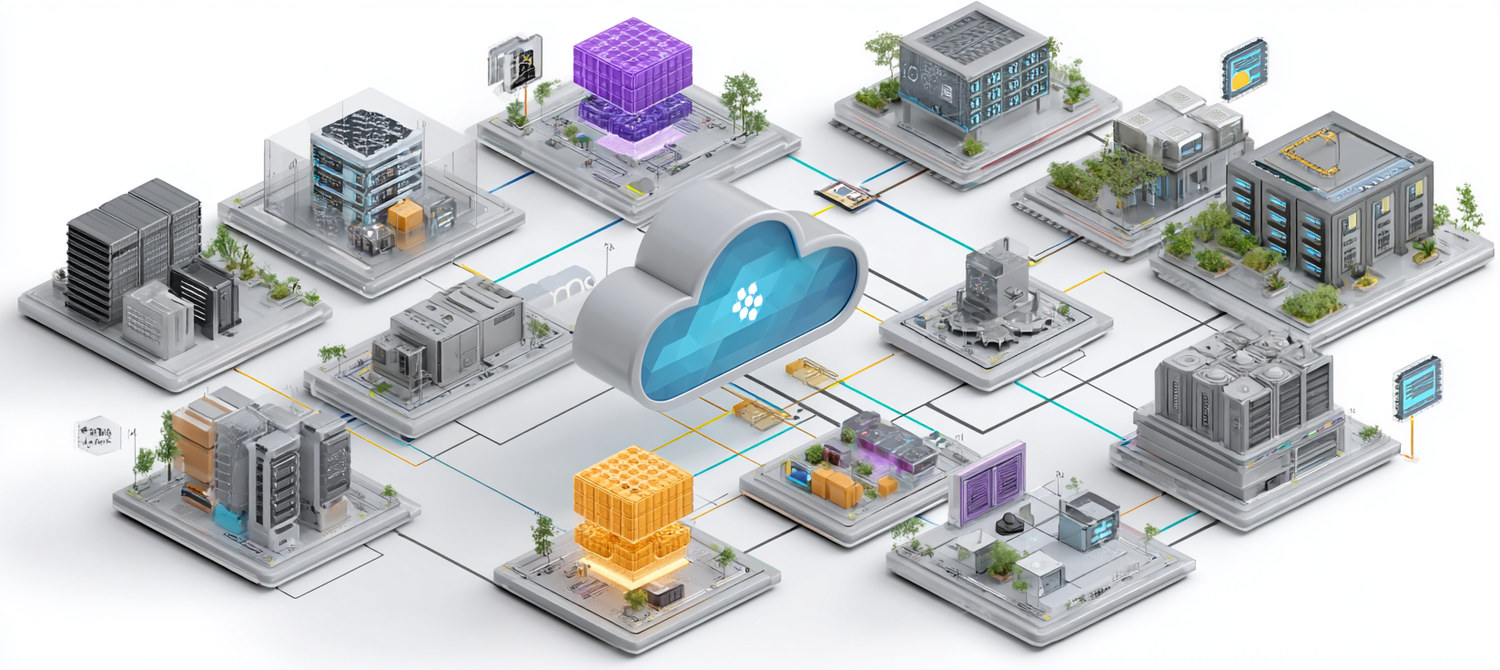

Основные инструменты в экосистеме DevOps

Идеи DevOps оживают благодаря технологиям. Это не один инструмент, а экосистема решений для автоматизации всего жизненного цикла ПО: от контроля версий и сборки до развертывания и управления инфраструктурой (IaC).

Системы контроля версий: Git и его роль

В мире DevOps всё начинается с кода. Это фундамент, на котором строятся все процессы. Поэтому управление кодом, отслеживание каждого изменения и организация совместной работы — ключевая задача №1. Здесь на сцену выходят системы контроля версий (VCS), и бесспорный король сегодня — Git.

Git — это распределённая система, ставшая стандартом в IT. В отличие от старых систем, где сбой сервера парализовал работу, в Git у каждого разработчика хранится полная и независимая копия истории. Это делает его надёжным и удобным для распределённых команд и open-source проектов по всему миру.

Почему Git — это сердце DevOps?

- Единый источник истины. Git-репозиторий — это центральное хранилище всего кода, скриптов и конфигураций. Все процессы автоматизации начинаются именно отсюда.

- Эффективная совместная работа. Механизм ветвления (branching) — ключевая возможность Git. Он позволяет разработчикам создавать изолированные ветки для новых функций, не мешая друг другу. Затем ветки сливаются в основной код.

- Прозрачность и безопасность. Git фиксирует каждое изменение, указывая автора и время. Это даёт полную историю проекта. Если новый код вызвал проблему, можно легко «откатиться» к предыдущей стабильной версии, минимизируя время простоя.

- Триггер для автоматизации. Команда `git push` — это не просто сохранение кода. В DevOps-культуре это событие служит триггером, запускающим весь конвейер CI/CD. Сервер автоматизации видит изменения и немедленно запускает сборку, тесты и другие шаги.

Важно понимать, что популярные платформы, такие как GitHub, GitLab или Bitbucket, — это не сам Git. Это сервисы, дающие веб-интерфейс, инструменты для код-ревью (Pull/Merge Requests) и встроенные CI/CD-пайплайны, что делает работу с Git ещё продуктивнее и удобнее.

Серверы автоматизации: Jenkins, GitLab CI, GitHub Actions

Серверы автоматизации — это мозг и сердце CI/CD. Они слушают события в Git (например, новый коммит) и запускают цепочку действий: сборку, тесты, развертывание. Это дирижёры, которые превращают набор скриптов в отлаженный конвейер. Выбор инструмента напрямую влияет на скорость и удобство автоматизации всего цикла разработки.

Рассмотрим трёх гигантов этой индустрии:

- Jenkins: Старейший и самый гибкий игрок. Его мощь — в гигантской экосистеме плагинов для любой задачи. Эта гибкость оборачивается сложностью настройки и поддержки, требуя экспертизы. Jenkins — это выбор для сложных, нестандартных проектов, где нужна максимальная свобода действий и кастомизация.

- GitLab CI/CD: Идеология “всё в одном”. Инструмент интегрирован в платформу GitLab, что исключает проблемы совместимости. Вся логика пайплайна описывается в YAML-файле .gitlab-ci.yml, который лежит прямо в репозитории. Это делает автоматизацию прозрачной и версионируемой вместе с кодом.

- GitHub Actions: Мощный и современный инструмент, встроенный в GitHub. Его главная особенность — огромный Marketplace готовых “действий” (actions). Это позволяет собирать сложные пайплайны из готовых, проверенных сообществом кубиков, что значительно ускоряет внедрение автоматизации.

Контейнеризация: Docker

Docker — это технология, которая изменила правила игры в разработке и эксплуатации, решив вечную проблему: «А на моей машине всё работало!». Контейнеризация позволяет упаковать приложение со всеми его зависимостями — библиотеками, системными утилитами, кодом — в один изолированный блок, называемый контейнером. Этот контейнер будет работать абсолютно одинаково на ноутбуке разработчика, на тестовом сервере и в продакшене. Docker стал стандартом де-факто в этой области.

Как Docker помогает DevOps?

- Гарантия консистентности окружений. Контейнер — это неизменяемый артефакт. Он исключает расхождения между средами разработки, тестирования и эксплуатации. Если приложение работает в контейнере на локальной машине, оно с той же вероятностью заработает и на любом другом сервере, где установлен Docker.

- Изоляция и безопасность. Приложения в контейнерах изолированы друг от друга и от хостовой системы. Это повышает безопасность и позволяет запускать на одном сервере несколько сервисов с конфликтующими зависимостями без каких-либо проблем.

- Скорость и эффективность. В отличие от виртуальных машин, контейнеры не содержат целой операционной системы. Они используют ядро хоста, поэтому запускаются за доли секунды и потребляют значительно меньше ресурсов. Это позволяет более эффективно утилизировать серверные мощности.

- Портативность. Docker-контейнер можно запустить везде, где есть Docker Engine, будь то локальный компьютер, корпоративный дата-центр или любое облако (AWS, Azure, Google Cloud). Это обеспечивает невероятную гибкость при развертывании.

В контексте CI/CD Docker используется на каждом шагу: для сборки кода в чистом окружении, для запуска тестов в изолированной среде и, конечно же, как финальный артефакт для развертывания в продакшен.

Оркестрация контейнеров: Kubernetes

Если Docker — это инструмент для создания и запуска отдельных контейнеров, то Kubernetes (часто сокращаемый до K8s) — это дирижёр для целого оркестра из сотен или тысяч таких контейнеров. Когда ваше приложение состоит из множества микросервисов, запущенных в десятках контейнеров на разных серверах, ручное управление ими становится невозможным. Kubernetes автоматизирует этот хаос, превращая его в управляемую, отказоустойчивую систему.

По своей сути, Kubernetes — это платформа-оркестратор с открытым исходным кодом, изначально разработанная в Google. Она позволяет автоматически развертывать, масштабировать и управлять контейнеризированными приложениями.

Ключевые задачи, которые решает Kubernetes:

- Самовосстановление (Self-healing). Если контейнер или даже целый сервер (узел) выходит из строя, Kubernetes автоматически перезапускает его или переносит на здоровую машину, обеспечивая непрерывную работу сервиса без вмешательства человека.

- Масштабирование. В зависимости от нагрузки, K8s может автоматически (или по команде) увеличивать или уменьшать количество работающих копий вашего приложения. Это позволяет экономно расходовать ресурсы и выдерживать пиковые нагрузки.

- Обновления без простоя (Zero-downtime deployments). Kubernetes позволяет обновлять приложение плавно, поочередно заменяя старые версии контейнеров на новые. Пользователи при этом не замечают никаких перебоев в работе.

- Декларативный подход. Вы не говорите Kubernetes “что делать”, вы описываете в YAML-файлах “какое состояние я хочу получить” (например, “три копии веб-сервера с такой-то версией”). А Kubernetes сам делает всё необходимое, чтобы привести систему в это состояние и поддерживать его.

Kubernetes стал отраслевым стандартом для запуска современных облачных приложений, обеспечивая их надежность и масштабируемость.

Инфраструктура как код (IaC)

Инфраструктура как код (IaC) — это революционный подход в DevOps, который предлагает управлять серверами, сетями, базами данных и другими компонентами IT-инфраструктуры не вручную через консоль или веб-интерфейсы, а через декларативные файлы с кодом. Вместо того чтобы инженер заходил на сервер и настраивал его командами, он описывает желаемое состояние системы в виде текстовых файлов. Эти файлы становятся единственным источником правды о состоянии инфраструктуры. Как и код приложения, они хранятся в системе контроля версий (Git), что позволяет их версионировать, рецензировать и тестировать.

Главные преимущества такого подхода:

- Полная автоматизация и скорость. Создание или изменение целых окружений, от тестовых песочниц до сложных продуктовых кластеров, сводится к запуску одного скрипта. Это занимает минуты, а не дни, что радикально ускоряет вывод продуктов на рынок и снижает затраты на ручной труд.

- Воспроизводимость и консистентность. IaC гарантирует, что тестовая и продуктовая среды идентичны. Это полностью исключает «дрейф конфигурации» — незадокументированные изменения, которые накапливаются со временем и приводят к трудноуловимым ошибкам во время выполнения.

- Версионирование и аудит. Каждое изменение инфраструктуры проходит код-ревью и сохраняется в истории Git. Легко понять, кто, что и когда изменил, и при необходимости мгновенно откатиться к предыдущей стабильной конфигурации.

- Сотрудничество и унификация. IaC стирает границы между разработкой и эксплуатацией. DevOps-команды работают с едиными унифицированными практиками и инструментами, что способствует их глубокой интеграции и общему пониманию системы.

Инструменты IaC: Terraform и Ansible

В мире Инфраструктуры как Кода (IaC) два инструмента занимают центральное место: Terraform и Ansible. Их часто сравнивают, но это не совсем верно. Они не конкуренты, а партнеры, каждый из которых идеально решает свою часть общей задачи автоматизации. Их совместное использование — залог построения мощного и гибкого CI/CD пайплайна.

Terraform: Архитектор вашей инфраструктуры

Terraform — это инструмент для провижининга, то есть создания инфраструктуры с нуля. Его философия — декларативность. Вы описываете в коде (на языке HCL), что хотите получить в итоге: «три сервера, одна сеть, один балансировщик». Terraform сам строит план и воплощает его в жизнь у любого крупного облачного провайдера. Его мозг — файл состояния (state), где он хранит память о созданных ресурсах, что позволяет безопасно вносить изменения и удалять инфраструктуру. Аналогия: Terraform по архитектурному чертежу возводит фундамент, стены и крышу дома.

Ansible: Мастер по настройке и конфигурации

Ansible, в свою очередь, — это система управления конфигурацией. Он вступает в игру, когда «дом» уже построен. Его задача — настроить серверы: установить ПО, разложить файлы, запустить сервисы. Он работает по процедурному принципу, выполняя шаги, описанные в понятных YAML-файлах (плейбуках). Главный козырь Ansible — безагентность: для работы ему нужен лишь SSH-доступ, что предельно упрощает старт. Аналогия: Ansible делает в доме чистовой ремонт, прокладывает коммуникации и расставляет мебель.

Синергия: Terraform + Ansible

Их истинная сила раскрывается в тандеме. Типичный сценарий: Terraform создает виртуальные машины, а затем автоматически запускается Ansible, который подключается к этим свежим серверам и настраивает на них приложение. Это обеспечивает полностью автоматизированное, повторяемое и надежное развертывание с нуля.

Построение эффективного CI/CD пайплайна

Построение эффективного CI/CD пайплайна — это создание автоматизированного конвейера, который безопасно и быстро доставляет код от разработчика к пользователю.

Это не хаотичный набор скриптов, а логическая цепочка этапов: от сборки и тестов до развертывания. Каждый шаг — это автоматический барьер качества.

Этап 1: Сборка кода и модульное тестирование

Это самый первый и фундаментальный этап всего CI/CD конвейера. Его можно сравнить с контролем качества на входе: если сырье (код) бракованное, нет смысла пускать его дальше по производственной линии. Этот этап запускается автоматически при каждом коммите в систему контроля версий (Git).

Шаг 1: Сборка (Build)

Сервер автоматизации (Jenkins, GitLab CI и др.) забирает свежие изменения из репозитория и пытается собрать из них рабочий продукт, или, как говорят, артефакт. Процесс зависит от языка программирования и технологии:

- Для компилируемых языков (Java, Go, C#) это процесс компиляции исходного кода в исполняемый файл или пакет (например, JAR-файл).

- Для интерпретируемых языков (Python, JavaScript) это может быть установка всех зависимостей и подготовка кода к запуску.

- В мире Docker это часто сборка нового Docker-образа на основе Dockerfile.

Главная цель: убедиться, что код в принципе не содержит синтаксических ошибок и может быть собран. Если сборка провалилась, пайплайн немедленно останавливается, и разработчик получает уведомление об ошибке.

Шаг 2: Модульное тестирование (Unit Testing)

Сразу после успешной сборки запускается набор модульных (юнит) тестов. Это самые быстрые и самые многочисленные тесты в проекте. Они проверяют не всё приложение целиком, а его мельчайшие изолированные части — отдельные функции или классы. Их задача — подтвердить, что каждая маленькая «шестеренка» в механизме работает так, как задумано, и что новые изменения не сломали уже существующую логику. Эти тесты должны выполняться за считанные секунды или минуты. Если хотя бы один юнит-тест провалился, сборка считается неудачной, и конвейер прерывается.

Успешное прохождение этого этапа даёт первую, базовую уверенность в качестве кода и создаёт готовый к дальнейшим проверкам артефакт.

Этап 2: Анализ качества кода и безопасности

Если первый этап ответил на вопрос «собирается ли код?», то этот отвечает на более сложные: «хорошо ли он написан?» и «безопасен ли он?». Это полностью автоматизированный и беспристрастный код-ревьюер, который проверяет код на соответствие стандартам качества и ищет уязвимости ещё до того, как артефакт попадёт в тестовую среду. Это яркий пример принципа «сдвига влево» (shift-left) — находить проблемы как можно раньше.

Статический анализ кода (SAST & Code Quality)

Здесь в дело вступают инструменты статического анализа, такие как SonarQube. Они сканируют исходный код, не запуская его, и ищут:

- Уязвимости безопасности: Потенциальные SQL-инъекции, «зашитые» в код секреты (пароли, ключи), небезопасные библиотеки.

- «Запахи кода» (Code Smells): Фрагменты, которые не являются ошибкой, но усложняют поддержку. Например, дублирование кода, слишком сложные методы.

- Потенциальные баги: Логические ошибки, которые пропустили юнит-тесты, например, утечки памяти.

Анализ зависимостей (Dependency Scanning)

Современные приложения — это конструктор из множества сторонних библиотек. Этот шаг автоматически проверяет все используемые зависимости на наличие известных уязвимостей (CVE) в публичных базах данных. Если найдена критическая уязвимость, сборка блокируется до тех пор, пока разработчик не обновит проблемную библиотеку до безопасной версии. Это защищает приложение от атак через чужой уязвимый код.

Этот этап — важнейший фильтр, который не пропускает дальше низкокачественный или небезопасный код, экономя время всей команды.

Этап 3: Развертывание в тестовые среды и интеграционное тестирование

После того как код собран, а его качество и безопасность проверены статически, наступает момент истины — первое «оживление» приложения. Этот этап переносит наш артефакт (например, Docker-образ) из мира исходного кода в работающую систему. Его цель — проверить, как отдельные, прекрасно работающие поодиночке компоненты, ведут себя в команде.

Автоматическое развертывание в «песочницу»

CI/CD конвейер автоматически разворачивает приложение в одно или несколько тестовых окружений. Эти среды (часто называемые QA, Staging) по своей конфигурации должны быть максимально точной копией продакшена. Здесь на помощь приходят технологии IaC (Terraform, Ansible), которые позволяют поднимать идентичные окружения по щелчку пальцев, гарантируя отсутствие сюрпризов при финальном релизе. Это генеральная репетиция перед выходом на большую сцену.

Проверка командной работы: Интеграционное и E2E тестирование

Когда приложение запущено, стартует серия более сложных и длительных тестов. В отличие от модульных, они проверяют не внутреннюю логику функций, а взаимодействие между частями системы:

- Интеграционные тесты: Проверяют корректность «диалога» между разными сервисами. Например, может ли сервис заказов правильно обратиться к сервису склада и получить ответ.

- API тесты: Удостоверяются, что все внешние точки входа (API) работают согласно контракту, отдают правильные данные и корректно обрабатывают ошибки.

- End-to-End (E2E) тесты: Эмулируют действия реального пользователя, проходя полный путь по бизнес-сценарию. Например, «пользователь заходит на сайт, добавляет товар в корзину, оформляет заказ».

Успешное завершение этого этапа дает высокую уверенность в том, что новая версия приложения не просто работает, а работает правильно как единое целое. Ошибка, найденная здесь, стоит в десятки раз дешевле, чем баг, дошедший до конечного пользователя.

Мониторинг и обратная связь в DevOps

В DevOps развертывание кода в продакшене — это не конец, а лишь начало нового витка. Мониторинг — это глаза и уши команды, которые непрерывно следят за здоровьем приложения и его влиянием на пользователей уже после релиза. Это основа для создания цикла обратной связи, где данные из эксплуатации (Operations) напрямую влияют на будущие решения в разработке (Development).

От железа до бизнеса: многоуровневый подход

Эффективный мониторинг — это не просто графики загрузки процессора. Это многослойная система, где каждый уровень дает свое понимание происходящего:

- Инфраструктурный уровень: Базовое здоровье серверов — CPU, память, диски. Это тот самый фундамент, без которого всё остальное не имеет смысла.

- Уровень приложения (APM): Глубокое погружение в код. Здесь отслеживаются медленные запросы к базе данных, ошибки, время ответа каждого микросервиса. Это помогает разработчикам быстро находить и устранять узкие места.

- Уровень пользователя (RUM): Взгляд на продукт глазами клиента. Как быстро загружается сайт в разных странах? С какими ошибками сталкиваются пользователи на своих реальных устройствах?

- Бизнес-уровень: Самый важный слой, связывающий IT с целями компании. Мониторинг ключевых бизнес-метрик (KPI) — количество регистраций, доход, конверсия — позволяет оценить, принесла ли новая функция реальную пользу.

Современные платформы, использующие AI и анализ больших данных, помогают автоматически выявлять аномалии и предсказывать сбои, превращая реактивное тушение пожаров в проактивное управление стабильностью. Собранные данные — это не повод для поиска виновных, а общее достояние команды для непрерывного улучшения продукта.